Тестирование inno3d geforce gtx 280. Компьютерный ресурс У SM

Однако вначале о технических особенностях. Являясь логичным развитием серий GeForce 8 и GeForce 9, представлявших первое поколение унифицированной визуальной вычислительной архитектуры NVIDIA, новинки семейства GeForce GTX 200 выполнены на базе второго поколения этой архитектуры.

Графические процессоры NVIDIA GeForce GTX 280 и 260 представляют собой наиболее массивные и сложные графические чипы из известных доселе – шутка ли, 1,4 миллиарда транзисторов в каждом! Наиболее производительное решение - GeForce GTX 280, обладает 240 шейдерными процессорами, 80 текстурными процессорами, поддерживает до 1 Гб видеопамяти. Подробные характеристики чипов GeForce GTX 280 и GeForce GTX 260 приведены в таблице ниже.

Спецификации NVIDIA GeForce GTX 280 и GTX 260 |

||

| Графическое ядро | ||

| Нормы технологического процесса | ||

| Количество транзисторов | ||

| Тактовая частота графики (в т.ч. диспетчера, модулей текстур и ROP) | ||

| Тактовые частоты процессорных модулей | ||

| Количество процессорных модулей | ||

| Тактовая частота памяти (частота/данные) | 1107 МГц / 2214 МГц |

999 МГц / 1998 МГц |

| Ширина интерфейса памяти | ||

| Пропускная способность шины памяти | ||

| Объём памяти | ||

| Количество модулей ROP | ||

| Количество модулей текстурной фильтрации | ||

| Производительность модулей текстурной фильтрации | 48,2 Гигатекселей/с |

36,9 Гигатекселей/с |

| Поддержка HDCP | ||

| Поддержка HDMI | Есть (адаптер DVI-HDMI) |

|

| Интерфейсы | 2 x Dual-Link DVI-I |

|

| RAMDAC, МГц | ||

| Шина | ||

| Форм-фактор | Два слота |

|

| Конфигурация разъёмов питания | 1 x 8-контактный |

2 x 6-контактных |

| Максимальное энергопотребление | ||

| Граничная температура GPU | ||

Фактически современное графическое ядро семейства GeForce GTX 200 можно представить как универсальный чип, поддерживающий два разных режима – графический и вычислительный. Архитектуру чипов семейств GeForce 8 и 9 обычно представляют массивами масштабируемых процессоров (Scalable Processor Array, SPA). Архитектура чипов семейства GeForce GTX 200 основана на доработанной и улучшенной архитектуре SPA, состоящей из ряда так называемых "кластеров обработки текстур" (TPC, Texture Processing Clusters) в графическом режиме или "кластеров обработки потоков" в режиме параллельного вычисления. При этом каждый модуль TPC состоит из массива потоковых мультипроцессоров (SM, Streaming Multiprocessors), и каждый SM содержит восемь процессорных ядер, также называемых потоковыми процессорами (SP, Streaming Processor), или тредовыми процессорами (TP, Thread Processor). Каждый SM также включает в себя процессоры текстурной фильтрации для графического режима, также используемый для различных операций фильтрации в вычислительном режиме. Ниже представлена блок-схема GeForce 280 GTX в традиционном графическом режиме.

Переключаясь в вычислительный режим, аппаратный диспетчер потоков (вверху) управляет тредами TPC.

Кластер TPC при ближайшем рассмотрении: распределённая память для каждого SM; каждое процессорное ядро SM может распределять данные между другими ядрами SM посредством распределённой памяти, без необходимости обращения к внешней подсистеме памяти.

Таким образом, унифицированная шейдерная и компьютерная архитектура NVIDIA использует две совершенно разные вычислительные модели: для работы TPC используется MIMD (multiple instruction, multiple data), для вычислений SM - SIMT (single instruction, multiple thread), продвинутая версия, SIMD (single instruction, multiple data). Касаясь общих характеристик, по сравнению с предшествовавшими поколениями чипов семейство GeForce GTX 200 обладает следующими преимуществами:

- Возможность обработки втрое большего количества потоков данных в единицу времени

- Новый дизайн планировщика выполнения команд, с повышенной на 20% эффективностью обработки текстур

- 512-битный интерфейс памяти (384 бита у предыдущего поколения)

- Оптимизированный процесс z-выборки и компрессии для достижения лучших результатов производительности при высоких разрешениях экрана

- Архитектурные усовершенствования для увеличения производительности при обработке теней

- Полноскоростной блендинг буфера кадров (против полускоростного у 8800 GTX)

- Вдвое увеличенный буфер команд для повышения производительности вычислений

- Удвоенное количество регистров для более оперативного обсчёта длинных и сложных шейдеров

- Удвоенная точность обсчета данных с плавающей запятой в соответствии со стандартом версии IEEE 754R

- Аппаратная поддержка 10-битного цветового пространства (только с интерфейсом DisplayPort)

- Поддержка NVIDIA PhysX

- Поддержка Microsoft DirectX 10, Shader Model 4.0

- Поддержка технологии NVIDIA CUDA

- Поддержка шины PCI Express 2.0

- Поддержка технологии GigaThread

- Движок NVIDIA Lumenex

- 128-битные вычисления с плавающей запятой (HDR)

- Поддержка OpenGL 2.1

- Поддержка Dual Dual-link DVI

- Поддержка технологии NVIDIA PureVideo HD

- Поддержка технологии NVIDIA HybridPower

Пользователь может конфигурировать систему на базе двух или трёх видеокарт семейства GeForce GTX 200 в режиме SLI при использовании материнских плат на базе соответствующих чипсетов nForce. В традиционном режиме Standard SLI (с двумя видеокартами) декларируется примерно 60-90% прирост производительности в играх; в режиме 3-way SLI – максимальное количество кадров в секунду при максимальных разрешениях экрана.

Следующая инновация – поддержка нового интерфейса DisplayPort с разрешениями выше 2560 х 1600, с 10-битным цветовым пространством (предыдущие поколения графики GeForce обладали внутренней поддержкой 10-битной обработки данных, но выводился только 8-битные компонентные цвета RGB). В рамках анонса новой серии графических процессоров семейства GeForce GTX 200 компания NVIDIA предлагает совершенно по-новому взглянуть на роль центрального и графического процессоров в современной сбалансированной настольной системе. Такой оптимизированный ПК , базирующийся на концепции гетерогенных вычислений (то есть, вычислений потока разнородных разнотипных задач), по мнению специалистов NVIDIA, обладает гораздо более сбалансированной архитектурой и значительно большим вычислительным потенциалом. Имеется в виду сочетание центрального процессора со сравнительно умеренной производительностью с наиболее мощной графикой или даже SLI-системой, что позволяет добиться пиковой производительности в наиболее тяжёлых играх, 3D и медиа приложениях. Иными словами, вкратце концепцию можно сформулировать так: центральный процессор в современной системе берёт на себя служебные функции, в то время как бремя тяжёлых вычислений ложится на графическую систему. Примерно те же выводы (правда, более комплексные и численно обоснованные) наблюдаются в серии наших статей, посвящённых исследованиям зависимости производительности от ключевых элементов системы, см. статьи Процессорозависимость видеосистемы. Часть I - Анализ ; Процессорозависимость видеосистемы. Часть II – Влияние объема кэш-памяти CPU и скорости оперативной памяти ; Ботозависимость, или зачем 3D-играм мощный CPU ; Процессорозависимость видеосистемы. Переходная область. "Критическая" точка частоты CPU . Впрочем, интенсивные вычисления с помощью современных графических видеокарт давно не новость, но именно с появлением графических процессоров семейства GeForce GTX 200 компания NVIDIA ожидает значительного повышения интереса к технологии CUDA. CUDA (Compute Unified Device Architecture) - вычислительная архитектура, нацеленная на решение сложных задач в потребительской, деловой и технической сферах - в любых приложениях, интенсивно оперирующих данными, с помощью графических процессоров NVIDIA. С точки зрения технологии CUDA новый графический чип GeForce GTX 280 это ни что иное как мощный многоядерный (сотни ядер!) процессор для параллельных вычислений. Как было указано выше, графическое ядро семейства GeForce GTX 200 можно представить как чип, поддерживающий графический и вычислительный режимы. В одном из этих режимов – "вычислительном", тот же GeForce GTX 280 превращается в программируемый мультипроцессор с 240 ядрами и 1 Гб выделенной памяти – этакий выделенный суперкомпьютер с производительностью под терафлоп, что в разы повышает результативность работы с приложениями, хорошо распараллеливающими данные, например, кодирование видео, научные вычисления и пр. Графические процессоры семейств GeForce 8 и 9 стали первыми на рынке, поддерживающими технологию CUDA, сейчас их продано более 70 млн. штук и интерес к проекту CUDA постоянно растёт. Подробнее узнать о проекте и скачать файлы, необходимые для начала работы можно . В качестве примера на приведённых ниже скриншотах показаны примеры прироста производительности вычислений, полученные независимыми пользователями технологии CUDA.

Подводя итог нашему краткому исследованию архитектурных и технологических улучшений, реализованных в новом поколении графических процессоров NVIDIA, выделим главные моменты. Второе поколение унифицированной архитектуры визуальных вычислений, реализованное в семействе GeForce GTX 200, является значительным шагом вперёд по сравнению с предшествовавшими поколениями GeForce 8 и 9.

По сравнению с предыдущим лидером GeForce 8800 GTX новый флагманский процессор GeForce GTX 280 обладает в 1,88 раза большим количеством процессорных ядер; способен обрабатывать примерно в 2,5 больше тредов на чип; обладает удвоенным размером файловых регистров и поддержкой вычислений с плавающей запятой с удвоенной точностью; поддерживает 1 Гб памяти с 512-битным интерфейсом; оборудован более эффективным диспетчером команд и улучшенными коммуникационными возможностями между элементами чипа; улучшенным модулем Z-буфера и компрессии, поддержкой 10-битной цветовой палитры и т.д. Впервые новое поколение чипов GeForce GTX 200 изначально позиционируется не только в качестве мощного 3D графического акселератора, но также в качестве серьёзного компьютерного решения для параллельных вычислений. Ожидается, что видеокарты GeForce GTX 280 с 1 Гб памяти появятся в рознице по цене порядка $649, новинки на базе GeForce GTX 260 с 896 Мб памяти – по цене около $449 (или даже $399). Проверить, насколько рекомендованные цены совпадают в реальной розницей, можно будет уже совсем скоро, поскольку по всем данным анонс семейства GeForce GTX 200 отнюдь не "бумажный", решения на этих чипах объявили многие партнёры NVIDIA, и в самом ближайшем времени новинки объявятся на прилавках. Теперь переходим к описанию первой видеокарты GeForce GTX 280, попавшей в нашу лабораторию, и к результатам её тестирования.

Выход нового графического процессора GT200 от компании NVIDIA геймеры всего мира и оверклокеры, в частности, ждали с нетерпением. Немудрено, так как фактически с далёкой осени 2006 года ничего действительно нового и революционного компания не выпускала. Год и почти восемь месяцев - срок небывалый для данного сектора Hi-Tech. C момента релиза G80 в сегменте высокопроизводительных чипов появился разве что G92, по большому счёту являющийся лишь переводом G80 на более тонкий техпроцесс с несущественными для геймера изменениями и снижением себестоимости. На самом же деле, те, кто в то время приобрел GeForce 8800 GTX (а немногим позже и GeForce 8800 Ultra), ничего лучшего позволить себе не могли, даже при наличии средств и желании вложить их в видеокарту(ы). Как вариант, для роста производительности можно было рассматривать появившуюся недавно GeForce 9800 GX2 или чрезмерно дорогие 3-Way SLI системы, но всё-таки нужно признать, что называть эти решения новыми и уж тем более революционными, было бы по меньшей мере некорректно.

Наконец, 16 июня 2008 года компания NVIDIA представила публике свой новый графический процессор GT200. Выпущенный по 65-нм техпроцессу чип, содержит около 1400 миллионов транзисторов – небывалая доселе величина. Инженеры компании в купе с маркетинговым отделом решили максимально расширить функциональность столь мощного GPU, наделив его наконец возможностями расчётов "физики", расчётов в программе распределённых вычислений Folding@Home, способностью обработки изображений и даже кодирования видеоконтента. Поддержка технологии CUDA (Compute Unified Device Architecture), фактически воплощающая в действительность перенос вычислений с центрального процессора на GPU, также является приятным бонусом нового чипа. В общем, на просторах Интернет даже бытует мнение, что до анонса и выхода на рынок продуктов конкурента, компания NVIDIA решила не раскрывать всю мощь GT200, производительность которого пока ограничена драйверами.

Как бы то ни было, в настоящее время графический процессор GT200 лёг в основу двух видеокарт: GeForce GTX 260 и топовой GeForce GTX 280. Первая представляет собой несколько урезанную версию GTX 280, с меньшим числом потоковых процессоров, TMU и ROP, с пониженными частотами GPU и видеопамяти, объём которой также уменьшен в сравнении с оным у GTX 280, а также с более узкой шиной обмена с видеопамятью. Рекомендованная стоимость на GeForce GTX 260 заявлена на уровне 399 долларов США, а появление в розничной продаже произошло на пару недель позже, нежели GeForce GTX 280. Вторая видеокарта являет собой бескомпромиссное решение класса Hi-End с рекомендованной стоимостью в 649 долларов США. Розничные цены на момент анонса были традиционно завышены и нередко превышали отметку в 850 долларов США. С одной из таких видеокарт мы и познакомим вас в сегодняшней статье.

1. Обзор LeadTek WinFast GeForce GTX 280 1024 Мбайт

Видеокарта производства компании LeadTek приехала к нам в OEM упаковке, поэтому традиционного "обзора" коробки сегодня не будет. Однако, для полноты картины мы можем привести фото коробки с официального сайта компании:

Зато даже в OEM поставку включены самые необходимые аксессуары:

Перечислю их слева направо и сверху вниз:

- один переходник 15 pin DVI / D-Sub;

- адаптер-разветвитель с S-Video выхода на компонентный;

- два кабеля для подключения дополнительного питания видеокарты (восьмипиновый и шестипиновый разъёмы);

- DVD-диск с игрой Neverwinter Nights 2;

- компакт-диск с драйверами видеокарты;

- инструкция по установке видеокарты и драйверов.

Внешне видеокарта вовсе несущественно отличается от GeForce 9800 GTX. Её длина чуть более 270 мм, а вся лицевая сторона закрыта пластиковым кожухом системы охлаждения, в котором с правой стороны установлена турбина:

Всю конструкцию охлаждает небольшая турбина мощностью 5.76 Ватт, выпущенная компанией Protechnic:

Скорость вращения турбины регулируется автоматически в диапазоне от ~400 до ~1600 об/мин. Уровень шума не указывается даже производителем турбины, поэтому субъективно отмечу, что после отметки в 900~1000 об/мин уровень шума становится явно некомфортным. В целом же шум кулера GeForce GTX 280 по уровню и тональности практически такой же как и у GeForce 9800 GTX.

Теперь я предлагаю проверить эффективность референсной системы охлаждения GeForce GTX 280. Методика тестирования заключалась в десятикратном прогоне бенчмарка Firefly Forest из синтетического графического бенчмарка 3DMark 2006 в разрешении 1920 х 1200 с активированным полноэкранным сглаживанием степени 4х и анизотропной фильтрацией уровня 16х. Все тесты проводились в закрытом корпусе ASUS Ascot 6AR2-B системного блока (конфигурацию вентиляторов в нём вы можете найти ниже в разделе с методикой тестирования). Комнатная температура во время тестирования была равна 24 градусам Цельсия. Мониторинг осуществлялся с помощью RivaTuner v2.09. Стандартный термоинтерфейс во время тестирования был заменён на высокоэффективную термопасту Arctic Silver 5, нанесённую тонким слоем. При этом температуру графического процессора в пике нагрузки в сравнении с оригинальной термопастой удалось снизить на 4 градуса Цельсия.

В результате, температурный режим графического процессора видеокарты с номинальными частотами и при автоматической работе турбины системы охлаждения оказался следующим:

C учётом возросшей мощности, площади и прочих характеристик нового графического чипа, я бы не сказал, что температура видеокарты внутри корпуса системного блока является критической. Хотя 85 градусов Цельсия по GPU (после замены термоинтерфейса) и 70 по температуре окружения скорее всего скажутся негативно на температуре компонентов системного блока, даже несмотря на тот факт, что турбина СО выбрасывает практически весь нагретый видеокартой воздух за пределы корпуса.

Теперь выставляем скорость вращения турбины на максимум и снова проверяем температурный режим видеокарты:

Очевидна высокая зависимость эффективности работы радиатора кулера GeForce GTX 280 от скорости вращения турбины, так как снижение произошло аж на 12 градусов по графическому процессору и по 11 по температуре окружения. Неплохо. Жаль только, что уровень шума при этом слишком высок, чтобы эксплуатировать видеокарту в таком режиме постоянно. Уверен, что производители альтернативных систем охлаждения не заставят себя долго ждать и совсем скоро мы будем тестировать новинки для охлаждения GeForce GTX 280.

Пока же оверклокерский потенциал видеокарты проверялся со стандартной системой охлаждения, но на максимальных оборотах вращения её турбины. В результате частоту графического процессора удалось поднять до 695 МГц или на 15.5 % к номиналу. Шейдерный домен разгонялся асинхронно до частоты в 1420 МГц (или +8.7 % к номиналу). В свою очередь, видеопамять без потери в стабильности и качестве картинки удалось разогнать до впечатляющих 2600 МГц или +17.4 % к номиналу:

После разгона видеокарты, её температурный режим вырос несущественно:

Температура графического процессора возросла на 2 градуса Цельсия по отношению к номинальным частотам видеокарты, а температура окружения достигла 61 градуса, что также лишь на пару градусов больше, чем в номинале.

К сожалению, цены на новинку традиционно завышены и в рознице начинаются от 850 долларов США, что довольно далеко от рекомендованных 649 долларов. Кроме того, в настоящее время наблюдается дефицит видеокарт GeForce GTX 280, в том числе и в связи с этим ждать скорого снижения стоимости не приходится. В завершении данного подраздела статьи дополню, что BIOS LeadTek WinFast GeForce GTX 280 1024 Мбайт вы можете скачать из нашего файлового архива (

Наиболее производительным одночиповым решением доселе являлся GeForce GTX 280 - обладает 240 шейдерными процессорами, 80 текстурными процессорами, поддерживает до 1 Гб видеопамяти. Фактически современное графическое ядро семейства GeForce GTX 200 можно представить как универсальный чип, поддерживающий два разных режима – графический и вычислительный. Архитектуру чипов семейств GeForce 8 и 9 обычно представляют массивами масштабируемых процессоров (Scalable Processor Array, SPA). Архитектура чипов семейства GeForce GTX 200 основана на доработанной и улучшенной архитектуре SPA, состоящей из ряда так называемых "кластеров обработки текстур" (TPC, Texture Processing Clusters) в графическом режиме или "кластеров обработки потоков" в режиме параллельного вычисления.

При этом каждый модуль TPC состоит из массива потоковых мультипроцессоров (SM, Streaming Multiprocessors), и каждый SM содержит восемь процессорных ядер, также называемых потоковыми процессорами (SP, Streaming Processor), или тредовыми процессорами (TP, Thread Processor). Каждый SM также включает в себя процессоры текстурной фильтрации для графического режима, также используемый для различных операций фильтрации в вычислительном режиме.

Ниже представлена блок-схема GeForce 280 GTX в традиционном графическом режиме.

Переключаясь в вычислительный режим, аппаратный диспетчер потоков (вверху) управляет тредами TPC.

Кластер TPC при ближайшем рассмотрении: распределённая память для каждого SM; каждое процессорное ядро SM может распределять данные между другими ядрами SM посредством распределённой памяти, без необходимости обращения к внешней подсистеме памяти.

Таким образом, унифицированная шейдерная и компьютерная архитектура NVIDIA использует две совершенно разные вычислительные модели: для работы TPC используется MIMD (multiple instruction, multiple data), для вычислений SM - SIMT (single instruction, multiple thread), продвинутая версия, SIMD (single instruction, multiple data).

Касаясь общих характеристик, по сравнению с предшествовавшими поколениями чипов семейство GeForce GTX 200 обладает следующими преимуществами:

Возможность обработки втрое большего количества потоков данных в единицу времени

Новый дизайн планировщика выполнения команд, с повышенной на 20% эффективностью обработки текстур

512-битный интерфейс памяти (384 бита у предыдущего поколения)

Оптимизированный процесс z-выборки и компрессии для достижения лучших результатов производительности при высоких разрешениях экрана

Архитектурные усовершенствования для увеличения производительности при обработке теней

Полноскоростной блендинг буфера кадров (против полускоростного у 8800 GTX)

Вдвое увеличенный буфер команд для повышения производительности вычислений

Удвоенное количество регистров для более оперативного обсчёта длинных и сложных шейдеров

Удвоенная точность обсчета данных с плавающей запятой в соответствии со стандартом версии IEEE 754R

Аппаратная поддержка 10-битного цветового пространства (только с интерфейсом DisplayPort)

Так выглядит список основных характеристик новых чипов:

Поддержка NVIDIA PhysX

Поддержка Microsoft DirectX 10, Shader Model 4.0

Поддержка технологии NVIDIA CUDA

Поддержка шины PCI Express 2.0

Поддержка технологии GigaThread

Движок NVIDIA Lumenex

128-битные вычисления с плавающей запятой (HDR)

Поддержка OpenGL 2.1

Поддержка Dual Dual-link DVI

Поддержка технологии NVIDIA PureVideo HD

Поддержка технологии NVIDIA HybridPower

Отдельно отмечено, что DirectX 10.1 семейством GeForce GTX 200 не поддерживается. Причиной назван тот факт, что при разработке чипов нового семейства, после консультаций с партнёрами, было принято сконцентрировать внимание не на поддержке DirectX 10.1, пока мало востребованного, а на улучшении архитектуры и производительности чипов.

Основанная на пакете физических алгоритмов, реализация технологии NVIDIA PhysX представляет собой мощный физический движок для вычислений в реальном времени. В настоящее время поддержка PhysX реализована в более чем 150 играх. В сочетании с мощным GPU, движок PhysX обеспечивает значительное увеличение физической вычислительной мощи, особенно в таких моментах как создание взрывов с разлётом пыли и осколков, персонажей со сложной мимикой, новых видов оружия с фантастическими эффектами, реалистично надетых или разрываемых тканей, тумана и дыма с динамическим обтеканием объектов.

К реализации физических эффектов в играх уже давно стремятся многие девелоперы и разработчики игр. С каждым годом это направление становится все актуальнее. В современных играх взаимодействие объектов с окружающей средой осуществляется силами двух движков, набравших наибольшую популярность - Havok и PhysX.

Havok является старейшим движком, на котором пишется немало игр под PC и консоли. Еще в далеком 2006 году, тогда еще независимая ATI, демонстрировала ускорение физических эффектов силами видеокарт Radeon X1900XT. Однако позже Havok купила компания Intel, которая заявила, что физические эффекты будут рассчитываться данным движком силами процессоров.

PhysX был разработан компанией AGEIA, которая реализовывала "физику" акселераторами собственной разработки. Но так сложилось, что, не смотря на большую популярность этого движка среди разработчиков игр, реализация физических эффектов в играх силами специализированных ускорителей оказалась весьма спорной.

И вот в прошлом году компания NVIDIA купила AGEIA PhysX. Были сделано заявление, что посредством оптимизации драйверов движок PhysX будет адаптирован под использование видеокарт GeForce 8800GT и выше.

Ещё одно немаловажное новшество – новые режимы экономии энергии. Благодаря использованию прецизионного 65 нм техпроцесса и новых схемотехнических решений удалось добиться более гибкого и динамичного контроля энергопотребления. Так, потребление семейства графических чипов GeForce GTX 200 в ждущем режиме или в режиме 2D составляет около 25 Вт; при воспроизведении фильма Blu-ray DVD - около 35 Вт; при полной 3D нагрузке TDP не превышает 236 Вт. Графический чип GeForce GTX 200 может вовсе отключаться благодаря поддержке технологии HybridPower с материнскими платами на HybridPower-чипсетах nForce с интегрированной графикой (например, nForce 780a или 790i), при этом поток графики незначительной интенсивности попросту обсчитывается GPU, интегрированным в системную плату. Помимо этого, GPU семейства GeForce GTX 200 также обладают специальными модулями контроля энергопотребления, призванными отключать блоки графического процессора, не задействованные в данный момент.

Пользователь может конфигурировать систему на базе двух или трёх видеокарт семейства GeForce GTX 200 в режиме SLI при использовании материнских плат на базе соответствующих чипсетов nForce. В традиционном режиме Standard SLI (с двумя видеокартами) декларируется примерно 60-90% прирост производительности в играх; в режиме 3-way SLI – максимальное количество кадров в секунду при максимальных разрешениях экрана.

В рамках анонса новой серии графических процессоров семейства GeForce GTX 200 компания NVIDIA предлагает совершенно по-новому взглянуть на роль центрального и графического процессоров в современной сбалансированной настольной системе. Такой оптимизированный ПК, базирующийся на концепции гетерогенных вычислений (то есть, вычислений потока разнородных разнотипных задач), по мнению специалистов NVIDIA, обладает гораздо более сбалансированной архитектурой и значительно большим вычислительным потенциалом. Имеется в виду сочетание центрального процессора со сравнительно умеренной производительностью с наиболее мощной графикой или даже SLI-системой, что позволяет добиться пиковой производительности в наиболее тяжёлых играх, 3D и медиа приложениях.

прочем, интенсивные вычисления с помощью современных графических видеокарт давно не новость, но именно с появлением графических процессоров семейства GeForce GTX 200 компания NVIDIA ожидает значительного повышения интереса к технологии CUDA.

CUDA (Compute Unified Device Architecture) - вычислительная архитектура, нацеленная на решение сложных задач в потребительской, деловой и технической сферах - в любых приложениях, интенсивно оперирующих данными, с помощью графических процессоров NVIDIA. С точки зрения технологии CUDA новый графический чип GeForce GTX 280 это ни что иное как мощный многоядерный (сотни ядер!) процессор для параллельных вычислений.

Как было указано выше, графическое ядро семейства GeForce GTX 200 можно представить как чип, поддерживающий графический и вычислительный режимы. В одном из этих режимов – "вычислительном", тот же GeForce GTX 280 превращается в программируемый мультипроцессор с 240 ядрами и 1 Гб выделенной памяти – этакий выделенный суперкомпьютер с производительностью под терафлоп, что в разы повышает результативность работы с приложениями, хорошо распараллеливающими данные, например, кодирование видео, научные вычисления и пр.

Графические процессоры семейств GeForce 8 и 9 стали первыми на рынке, поддерживающими технологию CUDA, сейчас их продано более 70 млн. штук и интерес к проекту CUDA постоянно растёт. Подробнее узнать о проекте и скачать файлы, необходимые для начала работы можно здесь. В качестве примера на приведённых ниже скриншотах показаны примеры прироста производительности вычислений, полученные независимыми пользователями технологии CUDA.

По сравнению с предыдущим лидером GeForce 8800 GTX новый флагманский процессор GeForce GTX 280 обладает в 1,88 раза большим количеством процессорных ядер; способен обрабатывать примерно в 2,5 больше тредов на чип; обладает удвоенным размером файловых регистров и поддержкой вычислений с плавающей запятой с удвоенной точностью; поддерживает 1 Гб памяти с 512-битным интерфейсом; оборудован более эффективным диспетчером команд и улучшенными коммуникационными возможностями между элементами чипа; улучшенным модулем Z-буфера и компрессии, поддержкой 10-битной цветовой палитры и т.д.

Впервые новое поколение чипов GeForce GTX 200 изначально позиционируется не только в качестве мощного 3D графического акселератора, но также в качестве серьёзного компьютерного решения для параллельных вычислений.

Характеристики NVIDIA GeForce GTX 280

| Наименование | GeForce GTX 280 |

| Ядро | GT200 (D10U-30) |

| Техпроцесс (мкм) | 0.065 |

| Транзисторов (млн) | 1400 |

| Частота работы ядра | 602 |

| Частота работы памяти (DDR) | 1107 |

| Шина и тип памяти | GDDR3 512-bit |

| ПСП (Гб/с) | 141,67 |

| Унифицированные шейдерные блоки | 240 |

| Частота унифицированных шейдерных блоков | 1296 |

| TMU на конвейер | 80 |

| ROP | 32 |

| Shaders Model | 4.0 |

| Fill Rate (Mtex/s) | 48160 |

| DirectX | 10 |

| Интерфейс | PCIe 2.0 |

Революции не произошло, новый графический процессор GT200 и протестированная сегодня видеокарта GeForce 280GTX(285GTX , 295GTX) являются дальнейшим развитием унифицированной шейдерной архитектуры от компании NVIDIA. Новый графический процессор содержит большее количество функциональных блоков, чем у предшественников, что даёт ему право называться мощнейшим GPU на сегодняшний день.

О покупке которой размышлял с декабря прошлого года. До этого в моём ПК стояла ТОП модель 2008 года (дата релиза - 16 июня 2008), GeForce GTX 280. Я решил сравнить два этих решения, велика ли между ними разница в DX10 (и ниже, причём на "ниже" будет сделан основной упор) приложениях, всё же почти четыре года прошло. Итак, предлагаю ознакомиться с результатами странных (ибо мало кто такие "бенчи" гоняет на видеокартах ТОП уровня) тестов.

Во-первых расскажу, почему я решил тестировать видеокарты ТОП уровня разных лет в некотором роде нетрадиционных бенчмарках. Основной причиной стал факт, что тестов в современных играх и тестах и так полным-полно, потому разумнее представить на обозрение читателей нечто неординарное. Ещё одна важная причина, почему я решился на такой шаг - распространённое среди ревьюверов мнение, что новые видеокарты не прогрессируют в плане производительности в старых играх (в которых используются старые API, а не современные DX11 и иже с ним) и потому не показывают в них особого роста FPS.

Прежде чем приступить к тестам, я хочу показать, насколько короче GTX 680 моей старой видеокарты (референсной GTX 280 с кулером Thermalright HR-03 GTX):

Вид внутри системного блока со старой видеокартой:

Тоже самое, но с видяхой новой:

Как Вы могли заметить, камрады, свободного места стало несколько больше, чему я рад (со свободным пространством внутри старого Mid-Tower"а без кабель-менеджмента всегда туго, если установлено оборудование приличного уровня и не модульный БП). Я поставил небольшой (92мм) вентилятор Scythe Gentle Typhoon с невысокими оборотами, дабы тот обдувал область VRM, на всякий случай (GTX 280 это очень здорово помогало после смены СО).

Конфигурация тестового стенда и сами тесты

Материнская плата

- ASUS P8P67 PRO

Процессор

- Core i5-2500K @ 4.2ГГц

Кулер

- Thermalright Macho

Оперативная память

- Corsair XMS3 CMX4GX3M1A1600C7 (8ГБ)

Видеокарта

- Nvidia GeForce GTX 680 и GTX 280 (частоты обеих карточек референсные)

Блок питания

- Enermax Pro 82+ 625 ватт

Накопитель

- Intel 320 Series SSD 160ГБ

Монитор

- BenQ XL2410T

ОС

- Windows 7 Ultimate SP1 x64 (со всеми патчами, что выходили)

Версия драйверов ForceWare

- для GTX 680 и для GTX 280

Итак, сейчас мы узнаем, насколько и в каких тестах GTX 680 шустрее GTX 280... или, может быть, медленнее?

Открывает программу необычных тестов продукт 3Dfx Interactive из далёкого прошлого, бенчмарк WizMark - софтина, что датирована 1996 годом. У меня тогда ПК не было, играл на Playstation 1, что за славное время было...

| GeForce GTX 680 | GeForce GTX 280 |

|

|

|

Для того, чтобы бенчмарк шёл без ограничений по скорости, я форсированно выставил Vsync OFF (отключил вертикальную синхронизацию) в настройках драйвера ForceWare (тоже самое пришлось сделать и для некоторых других бенчмарков). Отставание GTX 680 в данном тесте я объясняю просто - карточка сама регулирует частоты как ей вздумается (а способа повлиять на её поведение я не знаю), потому из-за скоротечности теста (он идёт менее двух секунд) она вполне могла не успеть перейти из 2Д режима (с пониженными частотами) в 3Д, а потому результат не был столь высок, как у GTX 280, которой я с помощью задал фиксированные частоты для всех режимов (602/1296/1107МГц).

Следующий тест, что я решил прогнать - легендарная программа Final Reality , очень симпатичный по меркам 1997 года тест. Настройки по-умолчанию:

Результат выступления карточек:

| GeForce GTX 680 | GeForce GTX 280 |

|

|

|

Вновь лидирует GTX 280, вероятно, всё по той же причине - более высокие фиксированные частоты. Хотя странно, что в истинно 3Д бенчмарке GTX 680 капризничала - возможно она работала не на всю мощь, в режиме наподобие того, что используется для просмотра BluRay?

Пришла пора 3DMark 2000 , хотел погонять и 99-й, но не смог завести его под Windows 7.

| GeForce GTX 680 | GeForce GTX 280 |

|

|

|

Первая победа ТОПа Nvidia! Преимущество мизерное, но оно имеется. Посмотрим, что будет в следующем поколении "Марка".

| GeForce GTX 680 | GeForce GTX 280 |

|

|

|

Новинка обходит соперника, но крайне незначительно, разница составляет менее 2000 очков. Ну хоть в 2003-м 3DMark"е продукт на базе Kepler сможет себя достойно показать?

| GeForce GTX 680 | GeForce GTX 280 |

|

|

|

Ну наконец-то видно, за что отданы немалые деньги! Разница в производительности между решениями очень велика - почти двукратная. По-идее, дальше в тестах отрыв GTX 680 от GTX 280 будет только увеличиваться. По-идее...

| GeForce GTX 680 | GeForce GTX 280 |

|

|

|

Что-то как-то не очень воодушевляет такой результат. Хотя, возможно, разница в ~6700 очков является в данном бенчмарке весомой.. не помню уже

3DMark 2006 более суров к видеокарте, чем его предшественник, поглядим на выступление ТОПов разных лет.

| GeForce GTX 680 | GeForce GTX 280 |

|

|

|

Вот тут уже чувствуется конкретный отрыв GTX 680 от старичка GTX 280. Почти 10000 очков преимущества - весомый аргумент в пользу GTX 680.

Пришла пора для более-менее современного теста, речь о 3DMark Vantage . Гоняться он будет на двух пресетах - Performance и Extreme.

| Пресет Performance | |

| GeForce GTX 680 | GeForce GTX 280 |

|

|

|

Более чем двукратное преимущество новой видеокарты Nvidia над старой в относительно лёгком режиме. Что же будет в Extreme?

| Пресет Extreme | |

| GeForce GTX 680 | GeForce GTX 280 |

|

|

|

Тут уже преимущество почти 4-х кратное, что не может не впечатлять. Судя по всему, в ~новых (с DX10) играх GTX 680 покажет себя значительно лучше продукта 2008 года.

Прогнав почти все "Марки", пришла пора приступить к тестам не от компании Futuremark. Кто-нибудь слышал про AquaMark3 ? Вот сейчас мы его и погоняем, настройки будут указаны на скриншотах ниже.

| GeForce GTX 680 | GeForce GTX 280 |

|

|

|

Забавное дело - GTX 680 немного, но проиграл GTX 280. Как такое может быть - может знает кто? Вряд ли тут карточка снижала частоты во время теста, так почему же производительность ниже?

Теперь поглядим, как обстоят дела у GTX 680 в Cinebench 10 . Проводился только Open GL тест.

| GeForce GTX 680 | GeForce GTX 280 |

|

|

|

И вновь мы видим преимущество GTX 280 над гораздо более новой, быстрой (как бы) и дорогой (тут уж сомнений нет) видеокартой. Может быть дела будут лучше в более свежей версии этого бенчмарка?

Тестирование в Cinebench 11.5 . Вновь я ограничился лишь Open GL тестом.

| GeForce GTX 680 | GeForce GTX 280 |

|

|

|

GTX 680 в кои-то веки одержал победу над GTX 280, правда отрыв невелик.

Обычно я использую дефолтные настройки во всех тестах, но данная софтина отказалась корректно работать на каких-либо установках, кроме этих. Вот результат выступления видеокарт:

| GeForce GTX 680 | GeForce GTX 280 |

|

|

|

Несмотря на то, что тест старый, GTX 680 всё-таки удалось одержать в нём победу - значение FPS выше, чем у GTX 280 во всех подтестах.

| GeForce GTX 680 | GeForce GTX 280 |

|

|

|

Как видно, общая оценка у GeForce GTX 680 выше, чем у соперника, однако не во всех тестах он оказался круче (в GDI победу одержал GTX 280).

| GeForce GTX 680 | GeForce GTX 280 |

|

|

|

На выполнение задачи у GTX 680 ушло ~4.8 секунды, а у GTX 280 - ~58.4. Результат на лицо. Хммм... а что если попробовать аппаратное кодирование видео посредством всё тех же CUDA ядер?

Для обозначенных выше целей я выбрал программу Badaboom 2.1 ... о чём потом пожалел, но было уже поздно.

| GeForce GTX 680 | GeForce GTX 280 |

|

|

|

Как Вы понимаете, я сначала проводил все тесты на GTX 280, чтобы потом уже поставить GTX 680 и погонять с теми же целями её, но всего не предусмотришь и оказалось, что GTX 680 программой Badaboom не поддерживается, ибо разработчики на своё детище забили и новых версий можно не ждать. Надо было использовать другой софт, но на момент осознания этой мысли было уже поздно что-либо менять.

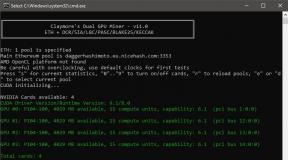

Ладно, с кодированием видео не получилось, а что насчёт взлома паролей посредством всё тех же CUDA ядер? Чтобы ответить на данный вопрос, я задействовал утилиту Crark 3.4e. Для теста был создан архив типа RAR, задан пароль из трёх символов (usm) и... всё.

| GeForce GTX 680 | GeForce GTX 280 |

|

|

|

GTX 680 способна перебирать 8058 паролей в секунду, потому на взлом архива у неё ушло 33.64 секунды. GTX 280 провозился дольше, его способности более скромные - 3141 пароль в секунду, общее время работы 1 минута и ~11 секунд.

Далее я решил провести ещё один тест, направленный на выявление вычислительного потенциала GTX 680, для этого была выбрана софтина DirectCompute & OpenCL Benchmark 0.45 . Тест проводился на профиле cs_4_0, что доступен обеим видеокартам.

| GeForce GTX 680 | GeForce GTX 280 |

|

|

|

Казалось бы - всё здорово, новинка бьёт "старинку" своей невероятной многоCUDAядерной мощью, но вот незадача - после прохождения подтеста DirectCompute на GTX 680 вылезала вот такая ошибка:

При этом тест OpenCL заканчивался удачно:

В чём причина ошибки, мне неведомо. Казалось бы - ерундистика, но всё же как-то нехорошо, что такая штука случилась. Надеюсь, что дело в софте (мало ли, не совместим с новинкой от Nvidia), хотя если и так, то тут всё глухо - более новой версии программы не существует.

Следующая программа в списке тестов - Lightsmark 2008 , тут уже CUDA ядрам ничего считать не нужно, это обычный графический бенчмарк. Настройки по-умолчанию (видны на скриншотах ниже).

| GeForce GTX 680 | GeForce GTX 280 |

|

|

|

В этом тесте GTX 680 показала себя хорошо - мы видим более чем двукратный прирост FPS.

Теперь пришла пора программы LuxMark 2.0 . Тут вновь задействуются CUDA ядра изделий, происходят вычисления OpenCL.

| GeForce GTX 680 | GeForce GTX 280 |

|

|

|

И тут мы видим двукратное преимущество новинки над старым решением. Не обращайте внимания на частоты на левом скриншоте - они фиксируются программой при старте, а GTX 680 к тому моменту их ещё не поднимает, т.е. не активирует 3D режим.

Ещё откопал забавные тесты, которыми баловался очень давно. Это Performance Test 3.4 (2001 год) и куда более новый его вариант - Performance Test 7 (не самый последний билд - 1004, от 2009 года).

| Performance Test 3.4 | |

| GeForce GTX 680 | GeForce GTX 280 |

|

|

|

Т.к. большинство тестов в данном бенчмарке происходит в 2Д режиме, то из-за пониженных частот у GTX 680 (поднимать их карточка не хотела ни под каким предлогом), победу одержала GTX 280, частоты которой, как я уже писал, были одинаково высоки для всех режимов работы.

| Performance Test 7 | |

| GeForce GTX 680 | GeForce GTX 280 |

|

|

|

В данном тесте мы вновь видим преимущество GTX 280 в 2Д режиме, а вот в 3Д GTX 680 себя показал, как и следовало ожидать. В общем зачёте победила более новая карточка, хотя результат мог бы быть более разгромным, если бы она в 2Д режиме выставляла максимальные частоты по команде (из того же Afterburner"а).

Далее я провел бенчмарк, разработанный на основе SVP его же создателями. Речь об SVPMark 3 , использовалась последняя доступная версия утилиты (3.0.3). Настройки по-умолчанию:

Вот как всё прошло, камрады:

| GeForce GTX 680 | GeForce GTX 280 |

|

|

|

Уж не знаю, по какой причине (может быть дело в драйверах даже), но SVPMark 3, ровно как и SVP, не стал корректно работать с GTX 680, потому итоговой оценки мы не увидим. С другой стороны, видна оценка в синтетическом тесте GPU, она чуть-чуть выше у новинки от Nvidia. Откровенно говоря, такой результат не впечатляет.

Пришла пора игровых бенчмарков. Тут я мудрить не стал, что было под рукой - то и запускал. Первым в очереди стоит Devil May Cry 4 , вот настройки, что были выставлены для тестов (по-сути это дефолт, не считая 120Гц развёртки):

А вот и сами тесты:

| GeForce GTX 680 | GeForce GTX 280 |

|

|

|

Обе видеокарты показали, что эта игра для них является довольно-таки простой задачей, полученная оценка - S. Но видно, что у GTX 680 количество кадров в секунду сильно выше, а значит просадка производительности от включения всяких там AA и AF будет меньше, чем у GTX 280.

Результаты тестов:

| GeForce GTX 680 | GeForce GTX 280 |

|

|

|

Видно неплохое преимущество GTX 680 над более старым представителем ТОПов от Nvidia. Однако, не сказать, чтобы упомянутое преимущество было разгромным.

Третий игровой бенчмарк и третья игра в материале от Capcom, это Resident Evil 5 . Он запускался в DX10, настройки видны на скриншоте ниже:

Вот что показали видяхи:

| GeForce GTX 680 | GeForce GTX 280 |

|

|

|

Да уж - от GeForce GTX 680 я ожидал несколько более высокого результата, чем преимущество в 0.4 FPS. Не впечатляет, как ни крути. Причины столь схожих результатов у видеокарт разных лет мне неизвестны.

Четвёртый игровой тест, снова игра от Capcom. Шутка! На деле, это позабытый многими S.T.A.L.K.E.R.: Чистое небо . Почему не "Зов Припяти"? Он у меня отказался по неведомой причине работать, надо было его переустанавливать, но дистрибутива под рукой не оказалось, а время поджимало. Настройки бенчмарка:

DX10.1 я не включал, т.к. GTX 280 его не поддерживает, думаю это всем ясно. Вот результаты тестов:

| GeForce GTX 680 | GeForce GTX 280 |

|

|

|

Вот где меня порадовала новая видеокарта! Игры серии "Сталкер" мне нравятся, потому приросту FPS в них я очень рад.

Последний игровой бенчмарк, крайне редко использующийся тест на базе игры Final Fantasy XIV . Настройки ниже:

Тест довольно дубовый, идёт только в окне, а сфоткать результат крайне сложно (экран с цифрами пропадает по нажатию любой клавиши, в том числе и PrintScreen).

| GeForce GTX 680 | GeForce GTX 280 |

|

|

|

GeForce GTX 680 обогнал своего соперника более чем в два раза, отрадно видеть такую картину хотя бы тут.

Выводы

На деле, общие выводы о новой видеокарте делать рано, из-за своей обычной нагруженности в будние дни, я не успел толком погонять реальные игры. Что же касается проведённых тестов, то тут ситуация складывается следующим образом - GTX 680 побеждает, но не во всех тестах, причём в некоторых, особенно старых, преимущество над GTX 280 крайне незначительно. Обидно, что прикручивая поддержку новых версий DirectX, всяких там тесселяций и прочего добра, мало что меняется в плане производительности в приложениях, где новые API не задействованы.

Пример - есть у меня игра Star Wars: Empire at War с установленным модом Thrawn"s Revenge (отличная штука для поклонников расширенной вселенной SW, кстати). Знаете сколько выдаёт в нём кадров при максимальных настройках в Full HD видеокарта GTX 280? Около 5. А как дела у GTX 680? Обстоят они ровно таким же образом. Вероятно, это не лучший пример, ибо игра, скорее всего, чрезвычайно процессорозависима, а тест проводился в режиме космической битвы с сотнями истребителями и десятками кораблей основных классов. С другой стороны если не на обычном геймплее проводить замеры, то на чём?

Experience high definition worlds, lifelike characters, and forces of nature so powerful that your palms sweat and your heart races with every frame. Beyond games, watch Blu-ray movies and transcode video up to 7X faster than traditional CPUs 1 .

| GEFORCE GTX 200 GPUs | GAMING BEYOND | BEYOND GAMING | ||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

|

Introducing NVIDIA GeForce GTX 280 and GeForce GTX 260

NVIDIA talks with developers about GeForce GTX 200 performance for their games

|

NVIDIA GeForce GTX 200 GPUs take gaming and effects beyond levels previously seen before

Medusa demo by NVIDIA and NVIDIA® PhysX™ Technology, and NaturalMotion.

|

More than just games - NVIDIA GeForce GTX 200 GPUs accelerate the latest consumer applications

1 The GeForce GTX 280 GPU ships with hardware support for NVIDIA PhysX technology. NVIDIA PhysX drivers are required to experience in-game GPU PhysX acceleration. Refer to for more information. Note: The below specifications represent this GPU as incorporated into NVIDIA"s reference graphics card design. Graphics card specifications may vary by Add-in-card manufacturer. Please refer to the Add-in-card manufacturers" website for actual shipping specifications. GPU Engine Specs:

Memory Specs:

Feature Support:

Display Support:

Standard Graphics Card Dimensions:

Thermal and Power Specs:

The number of processor cores may vary by model. |