Блог об настройках плагинов WordPress и поисковой оптимизаций для начинающих вебмастеров. Быстрый способ проверить индексацию страниц в Яндексе и Google Переиндексация страницы в яндексе сервис

Поисковые системы по ряду причин индексируют не все страницы сайта или, наоборот, добавляют в индекс нежелательные. В итоге практически невозможно найти сайт, у которого бы количество страниц в Яндексе и Google совпадало.

Если расхождение не превышает 10%, то на это не все обращают внимание. Но такая позиция справедлива для СМИ и информационных сайтов, когда потеря малой части страниц не сказывается на общей посещаемости. А вот для интернет-магазинов и прочих коммерческих сайтов отсутствие товарных страниц в поиске (даже одной из десяти) - это потеря дохода.

Поэтому важно хотя бы раз в месяц проверять индексацию страниц в Яндексе и Google, сопоставлять результаты, выявлять, какие страницы отсутствуют в поиске, и принимать меры.

Проблема при мониторинге индексации

Посмотреть проиндексированные страницы не составляет труда. Сделать это можно путем выгрузки отчетов в панелях для вебмастеров:

- («Индексирование» / «Страницы в поиске» / «Все страницы» / «Скачать таблицу XLS / CSV»);

Возможности инструмента:

- одновременная проверка проиндексированных страниц в Яндексе и Google (или в одной ПС);

- возможность проверки сразу всех URL сайта по ;

- нет ограничения по количеству URL.

Особенности:

- работа «в облаке» - не нужно скачивать и устанавливать ПО или плагины;

- выгрузка отчетов в формате XLSX;

- уведомление на почту об окончании сбора данных;

- хранение отчетов неограниченное время на сервере PromoPult.

Здравствуйте, уважаемые читатели сайта сайт. Сегодня я расскажу вам как найти и исправить возможные проблемы с индексированием вашего сайта. Рассмотрим три основных момента.

- Робот должен индексировать нужные страницы сайта с ;

- Эти страницы должны индексироваться быстро;

- Робот не должен посещать ненужные страницы сайта;

Кажется все довольно просто. Но на самом деле большинство вебмастеров сталкиваются с одними и теми же проблемами при настройке индексирования. Давайте посмотрим на них внимательно.

На текущий момент в большинстве случаев если речь идет о новой странице сайта в поисковую выдачу она появится в течение нескольких десятков минут. Если речь об уже проиндексированных страницах, то это 3-5 дней .

В итоге, чтобы ваш сайт посещался быстро необходимо помнить о трех правилах:

- Во-первых, у вас должен быть корректный и регулярно обновляемый файл sitemap;

- Во-вторых, не использовать директиву Crawl-delay просто если вам хочется. Прямо сейчас обязательно зайдите в ваш robots.txt и проверьте есть ли такая директива. Если она установлена задумайтесь, действительно ли она вам нужна.

- В-третьих, используйте "переобход страниц" для посещения роботом наиболее важных страниц вашего сайта с новой важной страницей.

Избавляем робота от ненужных страниц сайта

Когда робот начинает посещать ваш ресурс, часто это не всегда положительно влияет на индексирование хороших страниц сайта. Представим ситуацию, допустим, робот совершает 5 запросов в секунду к вашему ресурсу. Кажется отличный результат, но какой смысл из этих пяти посещений в секунду если все они относятся к служебным страницам вашего сайта или дублям и робот совсем не уделяет внимания действительно важным страницам. Об этом наш следующий раздел, как не индексировать ненужные страницы.

- Используем раздел Яндекс-вебмастер и статистику обхода

- Получаем адреса страниц, которые робот индексировать не должен

- Составляем корректный файл robots.txt

Давайте посмотрим на инструмент "Статистика обхода", выглядит он следующим образом. Здесь есть также графики. Нас интересует чуть-чуть пролистать вниз страницу кнопочка "все страницы". Вы увидите все, что посещал робот за последние дни.

Среди этих страниц если есть какие-то служебные страницы, то их нужно запрещать в файле robots.txt. Что именно нужно запрещать давайте по пунктам.

- Во первых, как я говорил ранее, страницы фильтрации , подборов товаров, сортировки нужно запрещать в файле robots.txt.

- Во-вторых, обязательно запрещаем страницы различных действий . Например, добавить в сравнение, добавить в избранное, добавить в корзину. Саму страницу с корзиной также запрещаем.

- В-третьих, запрещаем к обходу все служебные разделы такие как поиск по сайту, админку вашего ресурса, разделы с данными пользователей. Например, информация о доставке, номера телефонов и прочее также запрещаем в файле robots.txt.

- И страницы с идентификаторами , например с utm метками также стоит запретить к обходу в файле robots.txt с помощью директивы Clean-param.

Если вы столкнетесь с вопросом, а нужно ли запрещать или нужно ли открывать эту страницу к обходу, ответьте себе на простой вопрос: нужна ли эта страница пользователям поисковой системы? Если эта страница не должна находиться в поиске по запросам, то ее можно запретить.

И небольшой практический кейс, я надеюсь он вас замотивирует. Смотрите, на одном из ресурсов робот совершает практически тысячи обращений в день к страницам с редиректом. На самом деле, страницы перенаправления это были страницы добавления в корзину.

Вносим изменения в файл robots.txt и видно на графике, что обращение к таким страницам практически сошли на нет. При этом, сразу положительная динамика - обход нужных страниц этой странице степи кодом 200 резко возрос.

- Дубли страниц на сайте, как их найти и что с ними делать

И тут вас поджидает другая опасность - это дубли страниц . Под дублями мы понимаем несколько страниц одного сайта, которые доступны по разным адресам, но при этом содержат абсолютно идентичный контент. Основная опасность дублей заключается в том, что при их наличии может смениться в поисковой выдаче. Может попасть страница по ненужному вам адресу, конкурировать с основной страницей, которую вы продвигаете по каким-либо запросам. Плюс ко всему большое количество дублирующих страниц затрудняет обход сайта индексирующим роботом. В общем, проблем они приносят кучу.

Я думаю, что почти все вебмастера уверены, что именно на их ресурсе нет никаких дублирующих страниц. Хочу немножко вас расстроить. На самом деле дубли есть практически на всех сайтах в рунете. ? Об этом у меня есть подробная статья, прочитав которую, у вас не останется ни одного вопроса.

- Проверка кода ответа сервера

Помимо файла robots.txt хочется вам еще рассказать о корректных http кодах ответа. Тоже кажется вещи, которые говорили уже неоднократно. Сам по себе http код ответа это определенный статус страницы для индексирующего робота.

- http-200 - страницу можно индексировать и включать поиск.

- http-404 - значит страница удалена.

- http-301 - страница перенаправлена.

- http-503 - временно недоступна.

В чем плюс использования инструмента корректных http кодов:

- Во-первых, у вас никогда не будет различных битых ссылок на ваш ресурс, то есть тех ссылок, которые ведут на страницы, не отвечающие кодом ответа 200. Если страница не существует значит код ответа 404 это робот поймет.

- Во вторых, поможет роботу с планированием обхода действительно нужных страниц, которые отвечают кодом ответа 200.

- И в-третьих, позволит избежать попадания различного мусора в поисковую выдачу.

Об этом как раз следующий скрин также из практики. Во время недоступности ресурса и проведения технических работ робот получает заглушку с http кодом ответа 200.Вот как раз описание к этой заглушке вы видите в результатах поиска.

Поскольку страница отвечает кодом ответа 200 они попадают выдачу. Естественно, с таким контентом страницы не могут находиться и показывать по каким-либо запросам. В данном случае правильной настройкой будет http ответа 503. При кратковременной недоступности страницы или ресурса этот код ответа позволит избежать исключения страниц из результатов поиска.

Вот ситуации, когда ваши важные и нужные страницы вашего ресурса становятся недоступными для нашего робота, например, отвечают кодом 503 или 404 либо вместо них возвращается в об эту заглушку.

Такие ситуации можно отследить с помощью инструмента «важные страницы» . Добавьте в него те страницы, которые приносят наибольший трафик на ваш ресурс. Настройки уведомления на почту и либо в сервис и вы будете получать информацию о том, что происходит с данной страницей. Какой у нее код ответа, какой у нее заголовок, когда она посещалась и какой статус в поисковой выдаче.

Проверить корректность возврата того или иного кода ответа можно с помощью соответствующего инструмента в Яндекс-вебмастере (тут ). В данном случае проверяем код ответа несуществующих страниц. Я придумал страницу и загнал ее в инструмент, нажал кнопочку проверить и получил 404 ответ.

Здесь все в порядке, так как страница была недоступна она корректно ответила 404 кодом и в поиск она уже не попадет. В результате чего, для того, чтобы ограничить посещение роботам не нужных страниц сайта, активно используйте инструмент статистику обхода, вносите изменения в файл robots.txt и следите, чтобы страницы возвращали корректный http код ответа.

- Подводим итог

Мы с вами отдали роботу корректные странице сайта с контентом. Мы добились того, что это индексируется быстро. Запретили роботу индексировать не нужные страницы. Все эти три большие группы задач связаны между собой . То есть, если не ограничивать роботу индексирование служебных страниц, то, скорее всего, у него останется меньше времени на индексирование нужных страниц сайта.

Если робот будет получать контент нужных страниц не в полном объеме, он не будет включать эти страницы в поисковую выдачу быстро. То есть над индексированием вашего ресурса нужно работать в комплексе, над всеми этими тремя задачами. И в этом случае вы добьетесь определенных успехов для того, чтобы нужные страницы быстро попадали в поисковую выдачу.

Официальные ответы Яндекса

В индекс попали страницы в верхнем регистре при том, что сайт такого рода страниц не содержит. Если страницы попали в верхнем регистре, это скорее всего робот обнаружил ссылки на них где-то в интернете. Проверьте сначала ваш сайт, скорее всего где-то в интернете установлена некорректная ссылка. Робот пришел, увидел ее и начал скачивать страницу в верхнем регистре. Для них, для таких страниц лучше использовать 301 редирект.

Sitemap имеет несколько страниц - это нормально? Если речь едет о sitemap, то есть специальный формат sitemap, в котором можно указывать ссылки на другие файлы sitemap, то конечно нормально.

Если разместить ссылки на все разделы каталога в нижнюю часть сайта, который отображается на всех страницах, это поможет индексации или навредит? На самом деле делать этого совсем не нужно, то есть если это не нужно посетителям вашего сайта, то вносить специально это не нужно. Достаточно просто файла sitemap. Робот узнает о наличии всех этих страниц, добавит их в свою базу.

Нужно ли в sitemap указать периодичность обновления? Файлом sitemap можно передавать дополнительную информацию для индексирующего робота. Помимо самих адресов также наш робот понимает еще несколько тегов. Во-первых, это частота обновления, то есть периодичность обновления. Это приоритет при обходе и дата последнего изменения. Всю эту информацию из файла sitemap он забирает при обработке файла и добавляет в свою базу и использует в дальнейшем для корректировки политик обхода.

Можно ли обойтись без sitemap? Да, следите, чтобы на вашем сайте была прозрачная навигация, чтобы на любую внутреннюю страницу вели доступные ссылки. Но учитывайте, что если это новый ресурс (от автора: о том как запустить новый сайт читайте ) и, например, какая-то страничка находится глубоко на вашем сайте, например, в 5-10 кликов, то роботу потребуется достаточно много времени, чтобы узнать о ее наличии. Сначала скачать главную страницу сайта, достать ссылки, потом опять скачать те страницы, о которых он узнал и так далее. Файл sitemap позволяет передать роботу информацию обо всех страницах сразу.

Робот делает 700 тысяч запросов в сутки по несуществующим страницам. Прежде всего нужно понять откуда появились такие несуществующие страницы. Возможно некорректно используются относительные ссылки на вашем сайте, либо какой-то раздел удалили окончательно с сайта и робот продолжает все равно проверять такие страницы. В таком случае стоит их просто запретить в файле robots.txt. В течение 12 часов робот перестанет обращаться к таким страницам.

Если служебные страницы проиндексированы, как можно убрать их с поиска. Чтобы убрать страницы из результатов поиска также используйте robots.txt. То есть не имеет значение установили вы запрет при создании вашего сайта, либо уже когда запустили ресурс. Страница пропадет из выдачи в течение недели.

Автогенерируемый sitemap это хорошо или нет? В большинстве случаев все sitemap генерации автоматически, поэтому можно сказать, что это наверное хорошо. Вам не нужно делать что-то своими руками и можете уделить внимание чему-то другому.

Как будет индексироваться страница, если ее сделать канонической саму на себя. Если атрибут canonical ведет на саму же страницу? Такая страница считается канонической? Она будет нормально проиндексирована и включена в поисковую выдачу, то есть использовать такой прием вполне корректно.

Что означает статус "неканоническая"? З начит на странице установлен атрибут canonical, который ведет на другую страницу вашего сайта. Поэтому данная страница в поиск попасть не сможет. Откройте исходный код страницы, сделайте поиск, посмотрите куда ведет canonical и проверяйте каноническую страницу в поиске.

Что правильнее для страницы-корзины запрет в robots.txt или noindex? Если страница запрещена с помощью метода noindex, робот периодически будет посещать ее и проверять наличие данного запрета. Чтобы робот этого не делал, лучше используйте запрет в файле robots.txt.

До встречи! Успевайте всё и всегда на страницах блога сайт

Помоги проекту - подпишись на наш Яндекс.Дзен канал!

(13 )

Если вы хотите узнать, есть ли определенная страница в индексе поисковой системы и сколько в целом страниц вашего сайта участвуют в поиске, вам стоит узнать о четырех самых простых способах поверки индексации сайта, которыми пользуются все SEO-специалисты.

В процессе индексирования портала, поисковый бот сначала сканирует его, то есть, обходит для изучения контента, а затем добавляет информацию о веб-ресурсе в базу данных. Затем поисковая система формирует поиск по этим базам. Не путайте сканирование с индексацией – это разные вещи.

Чтобы понимать, сколько еще страниц вашего проекта не проиндексировано, нужно знать их общее количество. Это позволит понять, как быстро индексируется ваш сайт. Сделать это можно несколькими способами:

- Посмотреть карту сайта. Ее вы найдете по адресу: название_вашего_сайта.ru/sitemap.xml . Здесь показываются в основном показываются все страницы, размещенные на ресурсе. Но иногда карта сайта может генерироваться не правильно, и часть страниц в ней может не быть.

- Воспользоваться специальной программой. Эти программы сканируют весь ваш сайт и выдают все страницы вашего сайта, пример таких программ Screaming Frog Seo (платная) иди Xenus Links Sleuth (бесплатная).

Способы проверки индексации сайта

Предлагаем вашему вниманию 4 самых распространенных и простых способа, позволяющие проверить, какие страницы есть в индексе, а какие – нет.

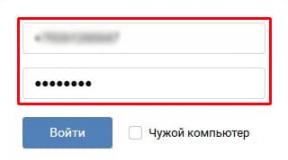

1. Через панель вебмастера

Этим методом владельцы веб-ресурсов проверяют их наличие в поиске чаще всего.

Яндекс

- Авторизуйтесь в Яндекс.Вебмастер .

- Перейдите в меню «Индексирование сайта» .

- Под ним найдите строку «Страницы в поиске» .

Можно пойти и по другому пути:

- Выберите «Индексирование сайта» .

- Дальше перейдите в «История» .

- Затем кликните на вкладку «Страницы в поиске» .

И первым, и вторым способом вы сможете изучить динамику роста или спада числа страниц в поисковой системе.

- Зайдите в панель управления сервиса Google Webmaster Tools .

- Кликните на вкладку Search Console .

- Перейдите в «Индекс Google» .

- Нажмите на опцию «Статус индексирования» .

2. Через операторов поисковых систем

Они помогают уточнить результаты поиска. Так, применение оператора «site» позволяет увидеть приблизительное число страниц, которые уже находятся в индексе. Чтобы проверить этот параметр, в строке поиска Яндекс либо Google укажите: «site:адрес_вашего_сайта»

.

Важно! Если результаты в Google и Яндекс сильно разнятся между собой, то значит ваш сайт имеет какие-то проблемы со структурой сайта, мусорными страницы, индексацией или на него наложены санкции.

Для поиска вы также можете использовать дополнительные инструменты, например, чтобы узнать, как изменялась индексация страниц за определенный период времени. Для этого под поисковой строкой нажмите на вкладку «Инструменты поиска»

и выберите период, к примеру, «За 24 часа»

.

3. Посредством плагинов и расширений

Используя специальные программы, проверка индексации веб-ресурса произойдет автоматически. Это можно сделать с помощью плагинов и расширений, еще известных как букмарклеты. Они представляют собой javascript-программы, которые сохраняются в браузере в виде стандартных закладок.

Преимущество плагинов и расширений в том, что вебмастеру нет необходимости каждый раз по новой заходить в поисковик и вводить там адреса сайтов, операторы и прочее. Скрипты произведут все в автоматическом режиме.

Самым популярным плагином, применяемым в этих целях, является RDS bar , который можно скачать в магазине приложений любого браузера.

Стоит отметить, что в Mozilla Firefox у плагина куда больше возможностей, чем в других браузерах. RDS bar предоставляет информацию относительно и всего веб-сайта, и его отдельных страниц

На заметку. Есть платные и бесплатные плагины. И самый большой минус бесплатных плагинов в том, что в них регулярно нужно вводить капчу.

Нельзя оставить без внимания и букмарклет «Проверка индексации» . Чтобы включить программу, просто перетяните ссылку на панель браузера, а затем запустите свой портал и нажмите на закладку расширения. Так вы откроете новую вкладку с Яндекс или Google, где изучите нужную информацию касательно индексации определенных страниц.

4. С помощью специальных сервисов

Я в основном пользуюсь сторонними сервисами, потому что в них наглядно видно какие страницы в индексе, а какие там отсутствуют.

Бесплатный сервис

https://serphunt.ru/indexing/ - есть проверка, как по Яндекс, так и по Google. Бесплатно можно проверить до 50 страниц в сутки.

Платный сервис

Из платных мне больше всего нравится Topvisor - стоимость 0.024р. за проверку одной страницы.

Вы загружаете в сервис все страницы вашего сайта и он вам покажет, какие находятся в индексе поисковых систем, а какие нет.

Заключение

Главная цель владельца любого веб-ресурса – добиться индексации всех страниц, которые будут доступны поисковым роботам для сканирования и копирования информации в базу данных. Реализовать эту задачу на большом сайте может быть очень непросто.

Но при правильном комплексном подходе, то есть, грамотной SEO-оптимизации, регулярном наполнении сайта качественным контентом и постоянном мониторинге процесса включения страниц в индекс поисковиков, можно добиться положительных результатов. Для этого мы в этой статье и рассказали о четырех методах проверки индексации сайта.

Знайте, что, если страницы слишком резко начали вылетать из поиска – с вашим ресурсом что-то не так. Но зачастую проблема таится не в процессе индексации, а в самой оптимизации. Желаете быстро индексироваться и попадать в ТОП выдачу поисковых запросов? Предлагайте целевой аудитории контент, превосходящий конкурентов.

Наполняя свой сайт полезной информацией, я постоянно думал над тем, как мне сделать, чтобы была быстрая индексация сайта , особенно в Яндексе. И я эту проблему решил. Теперь мои новые страницы сайта индексируются Яндексом за 10 минут. И это не шутка, а чистая правда. И поэтому в данной статье я решил вам дать информацию к действию, которая помогла мне ускорить индексацию сайта .

На самом деле ничего сложного и сверх естественного я вам не расскажу, так как я сам этого не сильно люблю. Я стремлюсь к простоте и легкости, но в то же время стремлюсь подвести свои действия к логичному завершению и результату.

Да, возможно эти результаты не всегда были положительными, но они были, а значит, в дальнейшем я стану умней, и работа моя станет, более, качественней.

Вы спросите, что я такое несу?

Я рассказую вам это неспроста, так как за счет таких экспериментов я добился быстрой индексации сайта в Яндексе за 10 минут. Возможно, это кажется не реально, но это факт. Я толком не успеваю понажимать по своим кнопкам социальных сетей, как моя новая страница сайта уже проиндексирована Яндексом.

В Google к сожалению такого результата нет, как бы я не старался. И раньше, чем за 6 часов мои новые страницы сайта в Google не индексируются. Но буду продолжать штудировать и работать дальше над поисковой системой Google.

Но в данной статье я хочу рассказать именно о Яндексе, а именно как на моем сайте происходит за 10 минут.

Возможно, многие те способы, которые я сейчас дам для быстрой индексации сайта, очень хорошо знают (это больше относится к более опытным блоггерам и веб-мастерам), но новичкам эта информация будет как раз кстати.

Я сейчас вам по пунктам распишу все действия, которые я делал для ускорения индексации своего сайта и которые в моем случае отлично работают. И так начнем.

Как сделать быструю индексацию сайта в Яндексе.

1 . Первым делом после того как я публикую свою статью в интернет, я добавляю ее в веб-мастер Яндекса в раздел "Сообщить о новом сайте ". Это первое, что каждый должен сделать для ускорения индексации своей станицы сайта. Обязательно зарегистрируйтесь там и на каждую новую свою статью ставьте там ссылку. Конечно, это не дает 100% гарантии быстрой индексации сайта в Яндексе, но и лишним не будет напомнить Яндексу о новой статье на вашем сайте.

2 . На моем сайте в конце каждой статьи есть кнопки социальных сетей , которыми я пользуюсь. Но пользуюсь я не всеми социальными сетями, которые там есть, а лишь несколько из них. Я добавляю свою новую страницу в такие социальные сети как: Twitter, Facebook, Я.ру и Google Plus. Вот все основные социалки, которыми я пользуюсь. Но перед этим вы должны, соответственно, зарегистрироваться в данных социальных сетях. Больше сервисов я не использую, так как считаю, что этого достаточно. Если у вас есть свои аккаунты еще где-то, то лишним это не будет.

4 . Добавляю свою новую страницу сайта в программу Pingxpertfree, которая раскидывает мою ссылку по своей базе сайтов в интернет. Их еще называют rss ленты.

5 . Пишу постоянно новые и уникальные статьи для своего сайта. Причем пишу их с постоянной периодичностью 1 статья в 3-4 дня, но не реже чем 2 статьи в неделю. Соответственно робот Яндекса приходит на мой сайт в данный промежуток времени и ждет новые посты, а как только они появляются, то Яндекс их тут же заносит себе в базу и в следствии происходит быстрая индексация сайта в Яндексе.

Старайтесь придерживаться графика появления новой статьи на вашем сайте. Приучите поискового робота заходить на ваш сайт постоянно в день появления новой статьи на сайте. Этот пункт является одним из главных. Самое главное постоянно наполнять свой сайт свежей информацией, и робот будет постоянно посещать ваш сайт.

6 . Сделайте грамотную и правильную внутреннюю перелинковку сайта . Суть ее заключается в том, чтобы все ваши статьи были связаны между собой ссылками. Это нужно для того, чтобы поисковый робот не уходил с той страницы, на которую он пришел, а перешел далее по внутренним ссылкам. Это особенно хорошо для молодого сайта, который только появился в интернете.

7 . Старайтесь наращивать ссылочную массу вашего сайта. Причем нужно, чтобы ссылки шли не только на главную страницу, а на все страницы сайта. Так будет быстрей и качественней индексация вашего сайта в Яндексе. Но не нужно в самом начале создания сайта или блога пользоваться сервисами для прокачки ссылочной массы, особенно, в большом количестве измеряемые в тысячном эквиваленте. Вместо «прогона» лучше использовать сервис типа SeoPult , в котором ссылки закупаются естественным образом, постепенно, и отбираются только качественные доноры, отвечающие жестким требованиям.

8 . Нужно постоянно вести контроль за индексацией своих страниц в интернете, в частности таких поисковых систем Яндекс и Гугл. Контроль за индексацией важен тем, что чем быстрее ваша статья попадет в поисковую выдачу, тем быстрее вы получите свою выгоду, которую вы преследовали в своей статье. Так же быстрая индексация статьи нужна, чтобы мошенники не смогли украсть ваш контент и проиндексировать быстрее у себя на сайте или блоге. Иногда, ваши страницы, которые уже проиндексировались в поисковых ситемах, через некотое время могут вылететь из поиска - это может быть глюк поисковых систем и вскоре ваши статьи вернуться обратно в поисковую выдачу либо какие-то проблемы обнаружились с вашими страницами сайта или блога и тогда вам нужно будет искать причину(ы) почему это произошло (причин может быть множество).

Чтобы ускорить процесс контроля за индексацией ваших страниц, существует бесплатный сервис https://serphunt.ru/indexing , который позволит быстро и бесплатно проверить индексацию вашей новой или старой страницы в поисковых системах Яндекс и Гугл. Данный сервис позволяет одновременно проверить до 50-ти страниц сайта или блога. Вот как выглядит сам сайт:

Вот и все способы, которые я применяю для моих новых написанных статей, чтобы была быстрая индексация сайта в Яндексе за 10 минут.

Но 100% гарантии я вам не даю, что будет именно такой результат, который есть у меня так, как неизвестно, как это будет работать на вашем сайте. Индексация штука тонкая и она зависит от многих факторов, которые нужно искать и заставить работать на себя.

P.S. Не огорчайтесь, если Яндекс не хочет долго индексировать ваш сайт. Возможно, у него нет пока доверия к вашему сайту. Главное не останавливаться и постоянно писать новые статьи и возможно в дальнейшем вы уже будете учить всех, как получить быструю индексацию сайта в Яндексе. Яндекс - поисковая система с характером и ей нужно угадить.

В последнее время август-сентябрь 2015 г. многие заметили, что Яндекс стал очень сильно косячить по части индексации страниц. Виной тому стал краш большого объема серверов и тем самым снижение мощностей краулеров Яндекса. Проще говоря робот Яндекса теперь дольше к вам идет и дольше обрабатывается полученные с ваших страниц данные. Как быстро переиндексировать свой сайт после переноса в текущих реалиях? Многие задают себе этот вопрос. Но нет конкретного руководства о том как же все таки это делать.

К сожалению, ситуация со столь длительным индексированием страниц Вашего сайта связана с ранее возникшими техническими проблемами с нашей стороны. В настоящий момент мы занимаемся их устранением, но, увы, на это потребуется время. (пример шаблонного ответа)

- тех.часть они чинят уже 2 месяц.

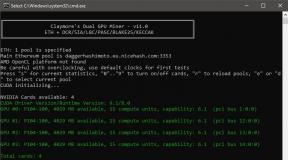

И так что нам потребуется для того чтобы быстро переиндексировать сайт:

- Сайт;

- Web-мастер яндекса

- Наличие прямых рук!

Что нужно сделать для переиндексации:

Шаг 1. Добавляем на проверку страницы

Если страниц не много, то все их добавить через сервис "Проверить URL" в Яндекс. Вебмастере.

Если страниц слишком много, то добавляем основные разделы и пока на этом шаге все. Можно воспользоваться как функционалом яндекс веб-мастер, так и : http://webmaster.yandex.ru/addurl.xml

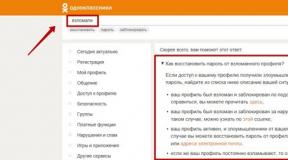

Шаг 2. Пишем в поддержку Яндекса. (честно не люблю я их сапорт, пока долезешь до него взбеситься можно!)

https://webmaster.yandex.ru/site/feedback.xml - задаем вопрос о сайте.

Кликаем: Мой сайт плохо индексируется =>Сайт полностью пропал из поиска => Рекомендации не помогли

Пишем правильное письмо в Яндекс.

Добрый день, большинство моих страниц которые ранее успешно находились в поиске и занимали позиции в топе вылетели из поискового индекса. Пожалуйста переиндексируйте мой сайт. И скажите в чем причина вылета моего сайта из индекса.

Приложите выгрузку CSV страниц из раздела. "Индексирование сайта" => "Исключенные страницы"

Это интерляцию придется повторить 2-4 раза, пока весь сайт не переиндексируется. Это единственный способ ускорить индексацию страниц сайта в Яндексе после переноса сайта на новый хостинг или домен.

Дополнительная информация. Яндекс стал чаще делать апдейты поисковой выдаче, в среднем это 3 дня против прошлых 10 дней. Стоит ожидать что к концу 2017 года скорость индексирования сайтов в рунете сильно возрастёт.

Как часто нужно отправлять страницы сайта на переиндексацию?

Исходя из своей практики, рекомендую делать это после каждого даже незначительного изменения в странице. Отправка на переиндексацию ускоряет обход роботом искомых страниц и как следствие изменения внесенные в них быстрее учитываются. Если же вы по большей части не меняли страница, то можно делать принудительный обход раз в 2-недели на основные разделы.